Expansão da IA, corrida regulatória e responsabilidade socioambiental

Artigo de opinião escrito pelo economista Antonio Corrêa de Lacerda* e pela professora Marília Bassetti Marcato**, publicado originalmente no Jornal dos Economistas

O rápido crescimento do mercado de Inteligência Artificial ocorre simultaneamente ao ressurgimento da política de grandes potências, ao aprofundamento da crise na ordem global multilateral e à influência crescente das gigantes da tecnologia nas relações internacionais. A este cenário, soma-se uma questão premente: a expansão da IA deverá vir acompanhada de um amplo compromisso com a responsabilidade socioambiental.

Até o ano de 2030, o mercado global de Inteligência Artificial deve superar a marca de US$ 1 trilhão. As principais estimativas indicam que o mercado global gastou US$ 46 bilhões em servidores de alto desempenho e servidores de IA generativa (aquela capaz não apenas de produzir textos, imagens e vídeos, mas também de fingir emoções e intimidade) em 2023, com previsão de chegar a US$ 77,6 bilhões em 20271.

A busca pelo desenvolvimento de IA autóctone ressalta o papel crítico da IA no reforço da soberania tecnológica dos países e na redução das dependências estratégicas. No entanto, paira um grande ceticismo quanto às estruturas de governança globais no campo da IA, tendo em vista as considerações éticas e implicações de uso dual da tecnologia, bem como o comportamento predatório das big techs em um mercado cada vez mais concentrado.

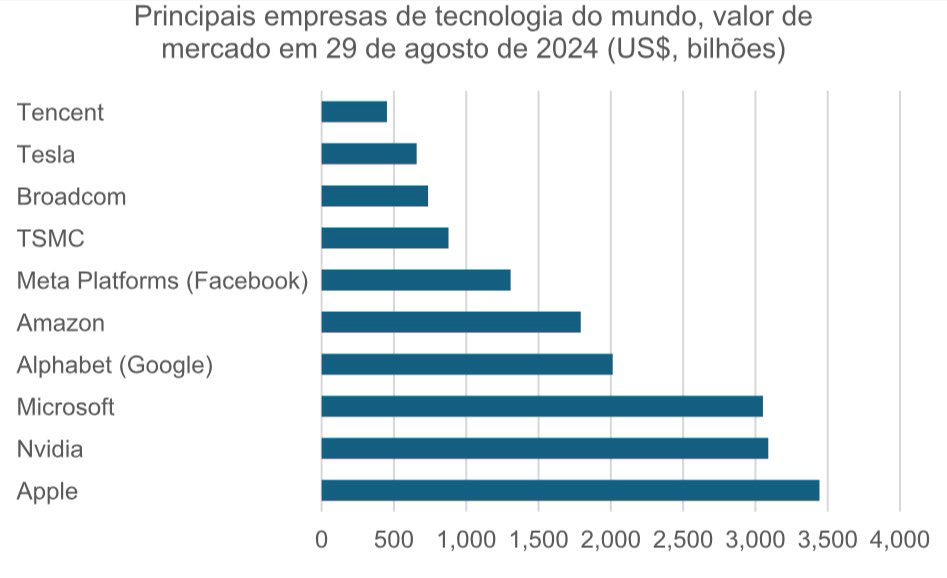

Big tech é o termo amplamente utilizado para se referir às gigantes da tecnologia, como Meta, Amazon, Apple, Google (Alphabet) e Microsoft, que exercem enorme poder econômico e cultural. Grande parte dessas empresas foi fundada a partir da década de 1970: a Microsoft (1975), a Apple (1976), a Google (1998) — que mais tarde passou a integrar a Alphabet (2015) — e a Meta, que surgiu como Facebook no ano de 2004.

Algo que chama a atenção no desenvolvimento e desempenho das big techs é a disparidade entre a sua valorização de mercado relativamente às empresas de setores tradicionais. O valor de mercado da Apple, por exemplo, conhecida pela concepção, design, desenvolvimento e comercialização dos iPhones e periféricos, atingiu cerca de US$ 3,5 trilhões, enquanto o valor de mercado da Foxconn, principal responsável pelas etapas manufatureiras dos mesmos aparelhos, chega a US$ 110 bilhões.

A atuação de tais empresas em mercados altamente concentrados tem levantado uma série de discussões a respeito da facilitação de comportamentos predatórios e dos potenciais danos associados. Nesse sentido, pode-se dizer que há uma maior consciência dos riscos associados ao domínio das plataformas digitais, ainda que não seja possível avistar atualmente uma convergência em termos das propostas de política para regulamentar as big techs e confrontar os problemas da economia digital.

O extraordinário crescimento da economia digital e a concentração dos mercados de atuação das big techs tornaram a proteção de dados e a privacidade uma preocupação central dos cidadãos e das autoridades reguladoras, internacionalmente. A relevância emergente dos dados pessoais tornou-os um ativo de mercado. Embora reconhecido como direito fundamental, o uso de dados pessoais implica a premência de aprimoramento do aparato regulatório envolvido. Nesse sentido, a regulação da atuação das big techs, além de evitar o abuso de poder de mercado por parte das empresas, pode ser uma aliada como instrumento de proteção da privacidade e uso de dados nos mercados digitais.

Fonte: CompaniesMarketCap.com.

Atualmente, há uma corrida internacional para regulamentar o uso de IA. Nesse sentido, é latente a necessidade de construir uma IA confiável e abordar os riscos gerados por usos específicos de IA, tendo em vista que os sistemas de IA estão em incessante transformação e podem amplificar riscos ou desafios sociais de maneiras imprevistas. Dentre esses, estão a exacerbação de desigualdades socioeconômicas, a exposição de vulnerabilidades de segurança e a restrição do acesso a benefícios tecnológicos, além da monopolização do desenvolvimento tecnológico e inovativo de sistemas de IA.

Em 2023, mais de sessenta países publicaram estratégias nacionais de IA. No nível nacional, de acordo com um relatório da Universidade de Stanford de 2023, foram 37 projetos de lei relacionados à IA aprovados por diferentes países em 2022. A maioria dessas regulamentações não apenas exige melhor análise e compreensão da IA e seus riscos e benefícios potenciais, mas também exige que os desenvolvedores de IA sejam responsabilizados pelas ações de suas invenções.

Nos Estados Unidos, vários documentos de orientação e estruturas voluntárias surgiram nos últimos anos, como a Estrutura de Gerenciamento de Riscos de IA do Instituto Nacional de Padrões e Tecnologia dos EUA (National Institute of Standards and Technology, Nist), publicada em janeiro de 2023, e o Projeto da Casa Branca para uma Declaração de Direitos de IA, um conjunto de princípios de alto nível emitido em outubro de 2023. Em fevereiro de 2024, Joe Biden nomeou Elizabeth Kelly como diretora do novo Instituto de Segurança de IA dos EUA (Usaisi) no Nist. Biden também anunciou a criação do U.S. AI Safety Institute Consortium. Este consórcio reunirá desenvolvedores de IA, pesquisadores, funcionários do governo, especialistas da indústria e representantes da sociedade civil em apoio ao avanço do desenvolvimento e implementação de IA segura e confiável.

A China demonstrou seu engajamento ativo na formulação de princípios e regulamentações para governar a IA, desde o Plano de Desenvolvimento de IA de Nova Geração de 2017 e iniciativas conduzidas por especialistas, como os Princípios de Governança para IA de Nova Geração de 2019 até, mais notavelmente, as Medidas de 2023 para a Gestão de Serviços de IA Generativa. Na União Europeia, a Lei de IA da União Europeia (UE) busca regular o uso de sistemas de IA com base em níveis de risco, refletindo um compromisso com o desenvolvimento responsável e centrado no ser humano da IA2. Com a Lei de IA, a UE visa a abordar tais riscos por meio de um conjunto de regras complementares, proporcionais e flexíveis. A estrutura legal definida pela lei é baseada em quatro níveis de risco e introduz regras dedicadas para modelos de IA de propósito geral.

A UE vê o estabelecimento de um padrão global por meio da Lei de IA da União Europeia como um objetivo fundamental, provocando discussões sobre uma corrida regulatória. Apesar da natureza inovadora da Lei de IA, ainda não se sabe como a UE navegará na interação entre princípios voluntários, códigos de conduta, leis brandas, normas e regulamentações vinculativas.

No âmbito da governança internacional, o desenvolvimento de IA Generativa levou a uma série de novas iniciativas, incluindo o Processo de Hiroshima do G7 de 2023 da OCDE sobre IA Generativa. Em outubro de 2023, a ONU anunciou a criação de um Órgão Consultivo de IA para emitir orientações sobre riscos, oportunidades e governança internacional da IA. Em novembro de 2023, o Reino Unido sediou a Cúpula de Segurança de IA, para estabelecer as bases para um regime global de segurança de IA. Como resultado, estabeleceu-se a Declaração de Bletchley, um compromisso conjunto de 28 governos e empresas líderes de IA que exigiu que modelos avançados de IA passassem por verificações de segurança antes da implantação.

Para além do esforço internacional para avançar na regulamentação da IA, a expansão da IA possui um efeito imediato que deve ser observado com muito cuidado: o crescimento exponencial do volume de processamento de dados exige muita energia. Estima-se que, em 2022, os data centers tenham demandado entre 240 e 500 terawatts-hora de eletricidade, cerca de 1% a 2% do consumo mundial, segundo a The Economist. Somente as quatro big techs (Amazon, Google, Meta e Microsoft), responsáveis por 80% da capacidade de data centers de hiperescala em 2022, utilizaram 72 terawatt-horas de eletricidade em 2021, mais que o dobro do seu uso em 2017, segundo a Agência Internacional

de Energia (IEA).

Portanto, criar a infraestrutura no entorno para abrigar esses data centers é um problema global. Vale lembrar que muitos projetos tiveram de ser interrompidos por falta de capacidade para fornecimento de eletricidade. Diante desse quadro, as big techs querem ser protagonistas de iniciativas de descarbonização. Com a expansão da IA aliada à necessidade de estabelecer um compromisso com a responsabilidade socioambiental, há uma grande oportunidade para o Brasil.

No governo Lula 3, há um avanço considerável no desenho das políticas públicas para transformação digital que buscam induzir o desenvolvimento produtivo e tecnológico com responsabilidade socioambiental. Um exemplo relevante é justamente a linha de financiamento para data centers lançada pelo BNDES, com cerca de R$ 2 bilhões para apoiar a criação de data centers alimentados com fontes de energia renováveis e tendo em vista um parâmetro de uso de recursos hídricos, priorizando as regiões Norte e Nordeste.

Dada sua matriz energética predominantemente limpa e renovável, o Brasil possui uma vantagem estratégica para liderar o desenvolvimento de uma infraestrutura de computação mais sustentável para dar suporte ao desenvolvimento de IA. Dessa forma, a geração distribuída mais sustentável é seguramente um dos grandes apelos da economia brasileira. Resta saber, ainda, se o país conseguirá se posicionar na corrida internacional para regulamentar o uso de IA.

* É professora do IE/UFRJ, vice-presidente da Associação Keynesiana Brasileira e assessora da presidência do BNDES. O artigo reflete a visão dos autores e não necessariamente a da instituição.

** É economista, doutor pelo IE/Unicamp, professor doutor do Programa de

Pós-graduação em Economia da PUCSP, ex-presidente do Cofecon e assessor da

presidência do BNDES. O artigo reflete a visão dos autores e não necessariamente

a da instituição.

1 https://ised-isde.canada.ca/site/ised/en/public-consultations/consultation-artificialintelligence-

ai-compute.

2 https://carnegieendowment.org/research/2024/03/charting-the-geopolitics-andeuropean-

governance-of-artificial-intelligence?lang=en¢er=europe.